Ist es niederschwellig möglich, auch ein LLM lokal zu installieren und zu nutzen? Dies Frage stellte sich mir nach der erfolgreichen Installation eines KI-Bildgenerators. Antwort: Ja, mit einer gewissen Hardware.

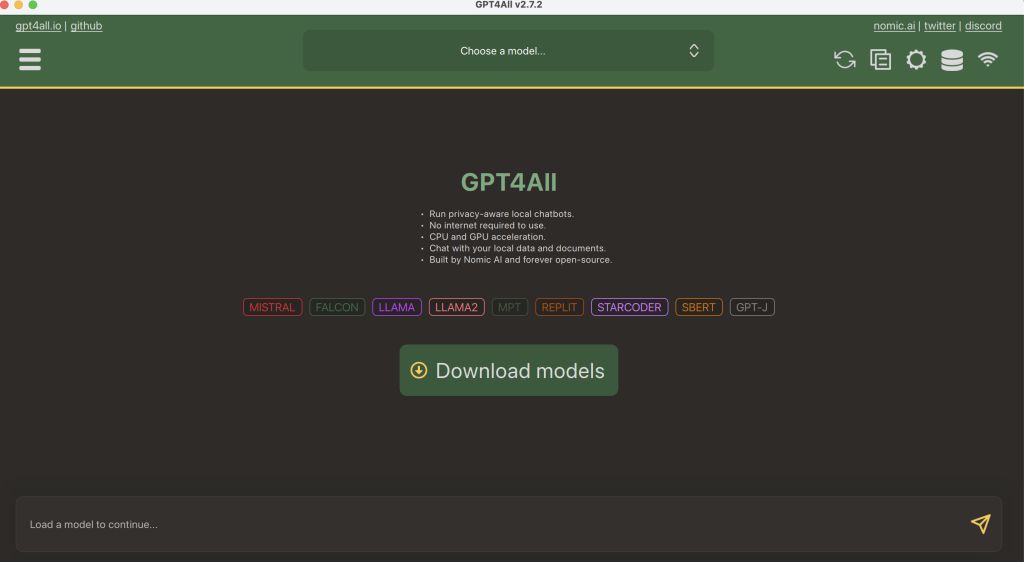

Ein Kollege (danke, Steffen) machte mich auf GPT4All aufmerksam. Hier gibt es Installer für verschiedene Betriebssysteme und man kann sich anschließend eines der dafür passenden Open-Source-Modelle herunterladen.

https://gpt4all.io

Auch hier habe ich mein MacBook Air (M1,2020) genutzt:

1. Download und Installation von OSX Installer mit Desktop Chat Client

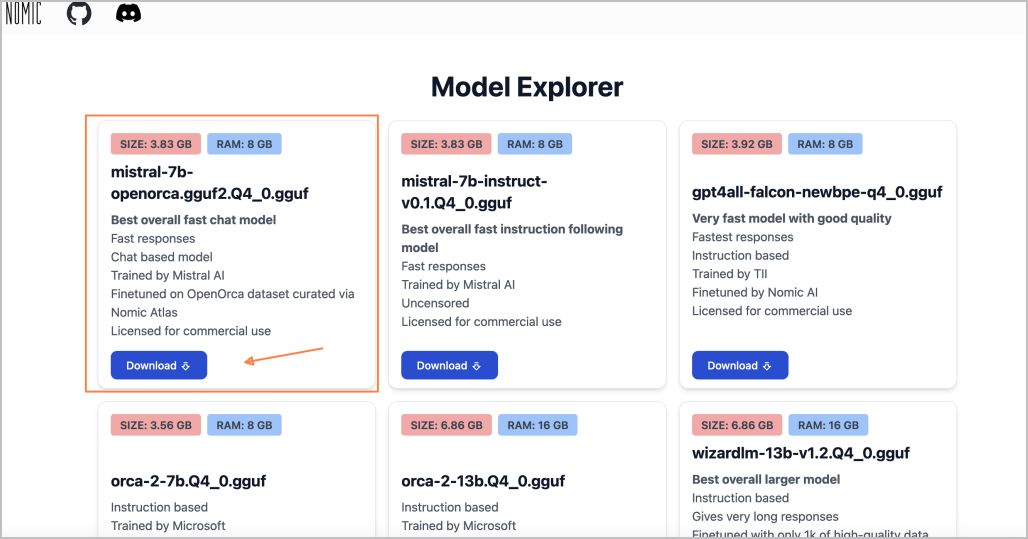

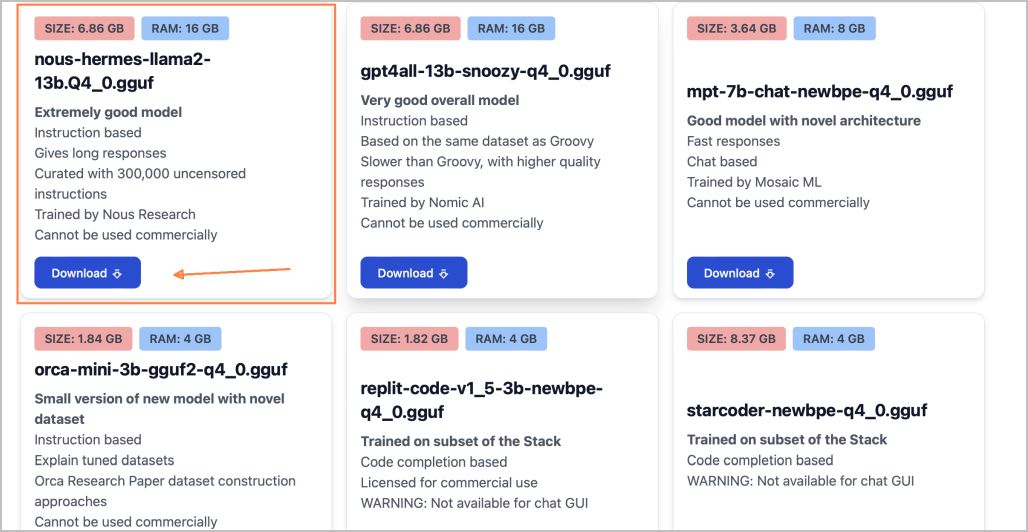

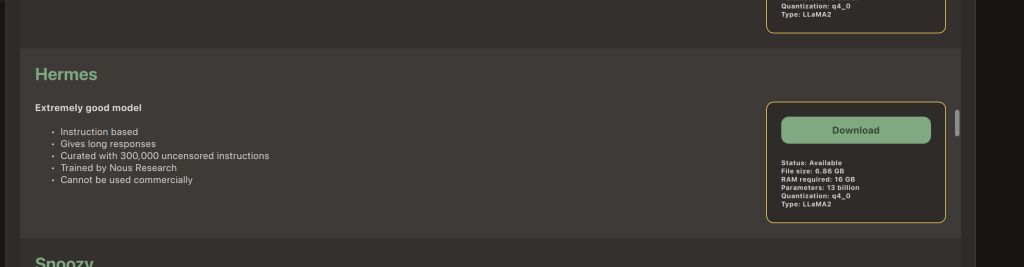

2. Anschließend Auswahl aus den angebotenen Sprachmodellen, hier Download eines Mistral-basierten und einem Llama2-basierten Modells

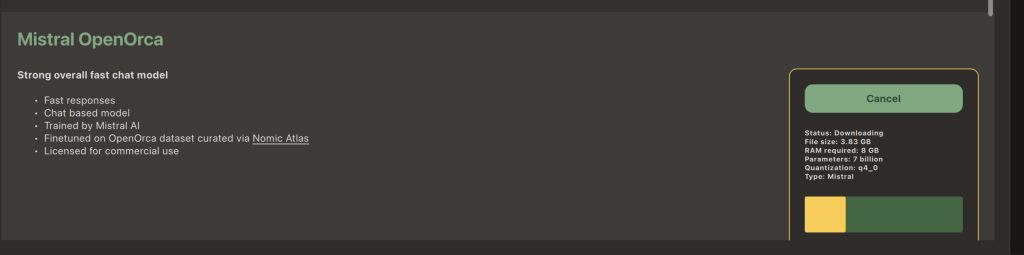

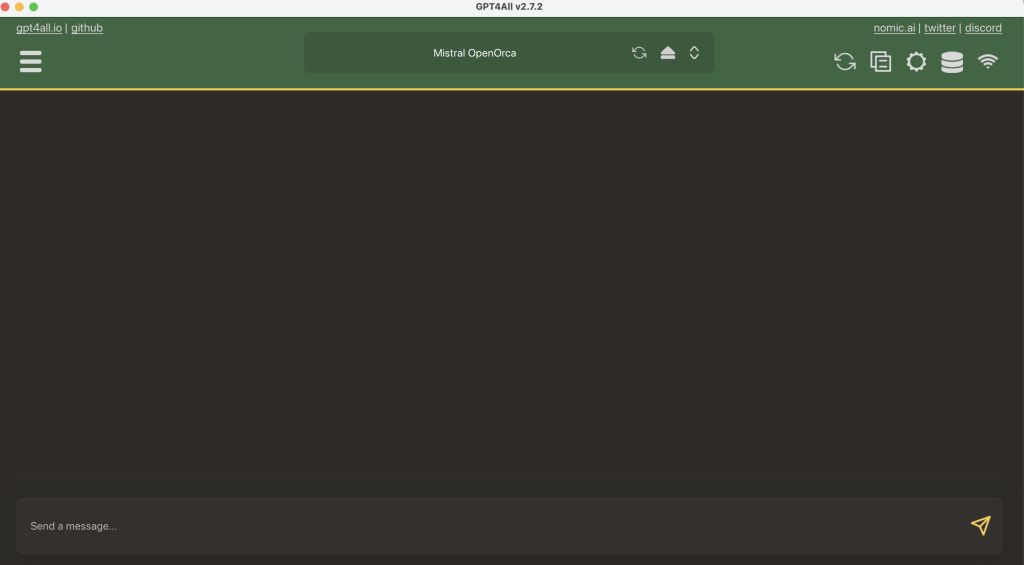

2a. Mistral OpenOrca 3,83GB (= mistral-7b-openorca.gguf2.Q4_0.gguf) sowie

2b. Hermes 6,86GB (= nous-hermes-llama2-13b.Q4_0.gguf)

3. Fertig, gewünschtes heruntergeladenes Modell oben auswählen und unten bei „Send a message“ Prompt formulieren

Die Antwortzeiten sind sehr gut und es funktioniert alles ohne Internet. Zunächst war ich bei meinen Prompts etwas irritiert über die Antworten – Mistral verstand die Bedeutung von poems nicht, mischte deutsch und englisch und fand 1kg Federn leichter als 1kg Wasser… Dies war bei Llama2 deutlich besser (das Modell ist auch fast doppelt so groß), aber nach und nach überzeugte mich auch Mistral bei weiteren Anfragen zu birthday cards, kleinen PHP-/HTML-Beispielen, sightseeing points, hybrid learning settings, PowerPoint presentations about Johannes Gutenberg, ski jumping, musical preferences etc.

Mein kurzes Fazit: OpenAI gefällt mir besser, aber das hätte ich auch nicht anders erwartet im Vergleich zu einer wirklich lokal laufenden Installation von OpenSource-Modellen – dennoch: Es lohnt durchaus, ein LLM einmal lokal zu installieren und auszuprobieren!