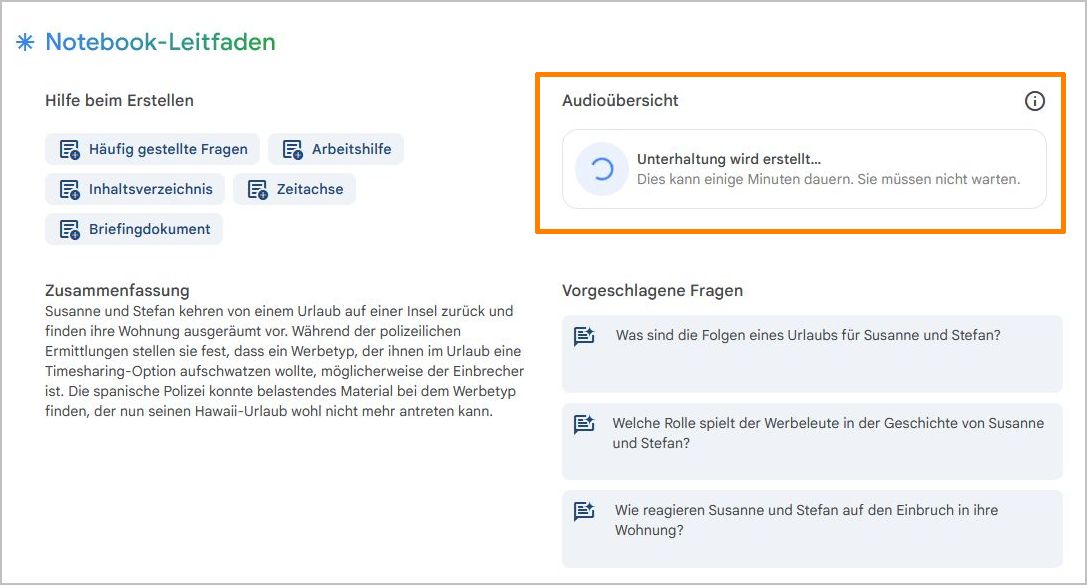

„NotebookLM now lets you listen to a conversation about your sources“ (s.a. https://blog.google/technology/ai/notebooklm-audio-overviews/)

Kurz gesagt, dieses Google-KI-Tool kann hochgeladene Dokumente in spannende Audio-Diskussionen („Podcast“) umsetzen.

Laut FAQ: „NotebookLM befindet sich noch in der frühen Testphase, daher werden derzeit keine Gebühren für den Zugriff erhoben.“

Im Folgenden ein Test auf der Grundlage einer fiktiven Kurzgeschichte, die ich schon vor längerer Zeit geschrieben habe. Aus einer einzigen DIN A4 Seite deutschen Textes machte NotebookLM knapp 10 Minuten thematische Diskussion auf englisch! Das unterhaltsame Audio-Ergebnis finde ich ausgesprochen beeindruckend, und es klingt so gar nicht mehr nach KI: Unten gerne zum Nachlesen und Vergleich des Originaltextes mit dem NotebookLM-Audio – viel Spaß!

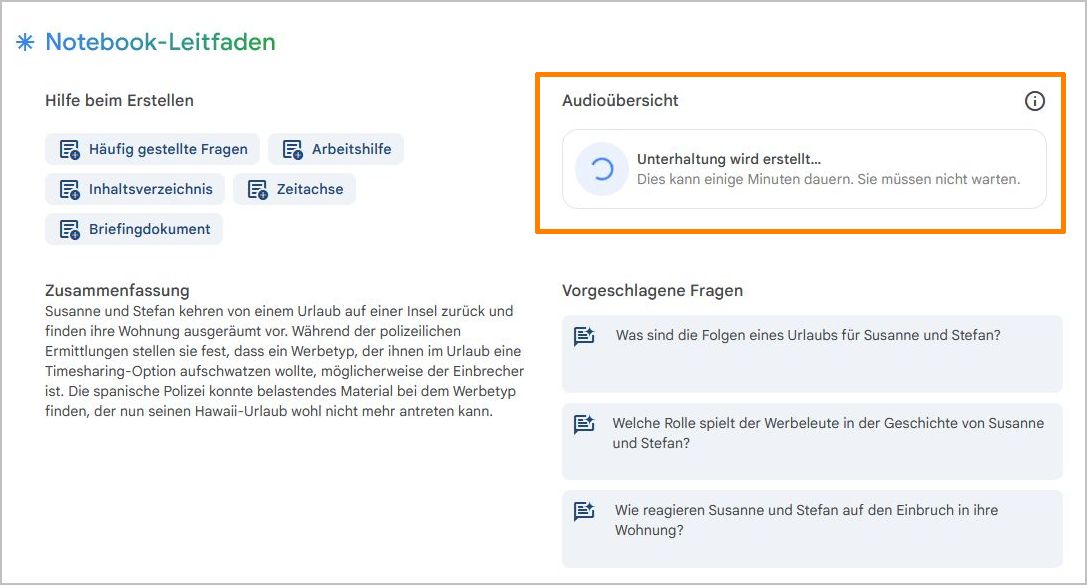

Vorgehensweise

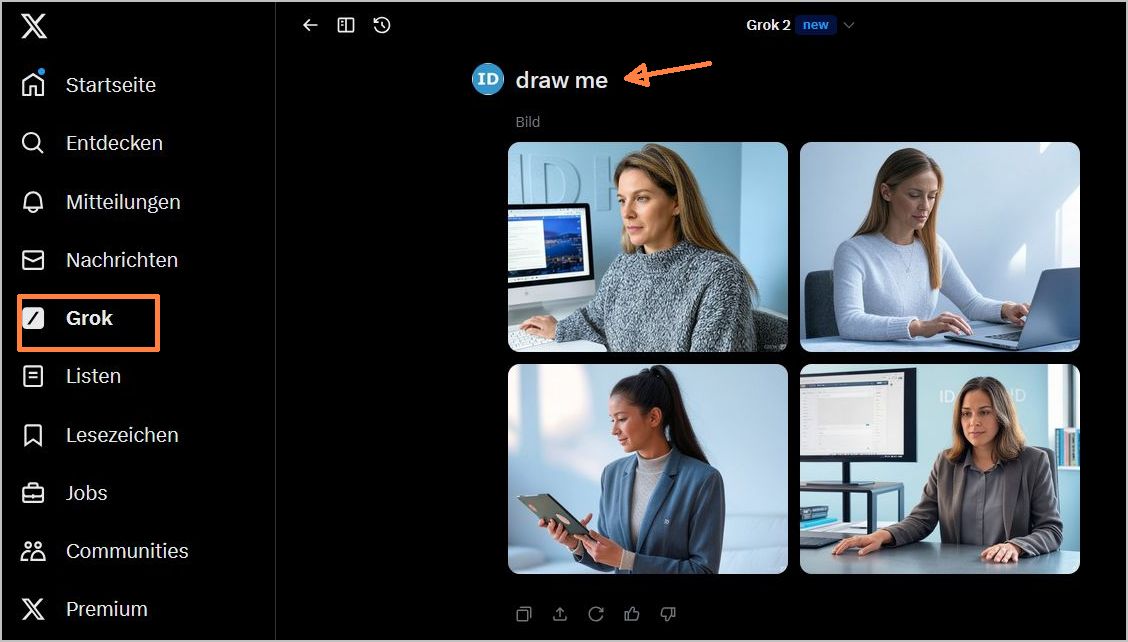

- http://notebooklm.google/

- Anmeldung mit persönlichem Google-Account

- Mindestens 1 Datei hochladen (z. B. Format PDF, txt)

- Rechts auf „Detaillierte Unterhaltung Zwei Hosts (nur auf englisch) – Generieren“ klicken und einige Minuten warten

- Download der „wav“-Datei und/oder Freigabe-Link erzeugen (zum Nutzen Google-Anmeldung nötig)

Originaltext meiner Kurzgeschichte

Urlaub mit Folgen

Susanne und Stefan blickten entgeistert auf das Durcheinander in ihrer Wohnung. Das war jetzt genau das, was man brauchte. Gestern hatten sie noch am Strand gelegen und sich auf zu Hause gefreut. Und nun war das einzig Erfreuliche, dass der Fischfutterautomat funktioniert hatte und das große Aquarium nebst Fischen aussah, als wäre man nicht 2 Wochen im Urlaub gewesen. Die Polizei konnte ihnen auch keine großen Hoffnungen machen. Es gab so viele Wohnungseinbrüche in der Stadt – gerade in besseren Wohnvierteln gehörte das inzwischen schon fast dazu. Doch so einfach wollten Susanne und Stefan es sich nicht machen. Wer hatte denn gewusst, dass sie nicht da waren? Die Arbeitskollegen natürlich, die Nachbarn, der Hausarzt – nein, solche Überlegungen führten nicht weiter. Und nun war alles weg: die Sammlung Eurocheques, die moderne Hifi-Anlage, sogar vor dem Computer hatten die Einbrecher nicht Halt gemacht. Wenigstens waren die Backup-Disketten noch da. Aber das Gefühl, dass womöglich jetzt jemand die geschäftlichen Daten und auch die privaten Briefe lesen würde, war ziemlich schockierend. Irgendjemand würde jetzt sehr viel von ihnen wissen. Ein Gespräch mit den Nachbarn ergab, dass sie vorgestern Abend ein paar Handwerker ins Haus gehen sahen. Aber wer denkt da gleich an Einbruch? Gut, also vorgestern war es dann wohl passiert. Während Stefan an seinem Schreibtisch saß und überlegte, stöhnte Susanne, dass sie doch lieber nur eine Woche auf der Insel hätten verbringen sollen und dass dann das alles nicht passiert wäre. Schließlich hätte es in der zweiten Woche sowieso nur ständig geregnet. Letzteres konnte Stefan nicht bestreiten; selbst die Einheimischen konnten sich nicht daran erinnern, wann es das letzte Mal um diese Jahreszeit derart viel geregnet hatte. Und dann waren da ja noch diese aufdringlichen Werbeleute gewesen, die ihnen am Anfang ihrer zweiten Woche unbedingt eine Timesharing-Option hatten aufschwatzen wollen. Natürlich nicht mit dieser Bezeichnung; dann hätte man sich ja nie auf ein Gespräch eingelassen, das stand ja schon im Reiseführer. Einen Ferientag hatten Susanne und Stefan damit verbracht, sich eine – zugegebenermaßen schöne – neue Ferienanlage anzuschauen. Naja, die Besichtigung und das Gespräch hatten über 2 Stunden gedauert und ein schon eingeplantes Mittagessen gekostet. Schlimmer war der Ärger, den sie nachmittags darüber empfunden hatten, zu höflich gewesen zu sein, um schon früher verärgert das Gespräch abzubrechen. Dieser Werbemensch war aber auch wirklich übel gewesen. Moment mal, könnte da etwa ein Zusammenhang bestehen zu dem Einbruch bei ihnen? Ein Anruf bei der Polizei konnte ja nicht schaden. Der Beamte, mit dem sie telefonierten, fand den Gedanken gar nicht so abwegig, wie sie befürchtet hatten und versprach, sich darum zu kümmern. Schließlich hatte man ja immerhin den Namen des Hotels, in dem die Veranstaltung stattgefunden hatte und mit etwas Glück war auch der Werbetyp noch da. Frank war der Name gewesen; er erzählte ihnen, er käme ursprünglich aus einem kleinen Ort bei Braunschweig. In 2 Monaten wollte er Urlaub auf Hawaii machen – etwas, dass man sich nur leisten könnte, wenn man Optionen bei seiner Urlaubsfirma erwerbe. Naja, vielleicht lag das aber wiederum eher daran, dass er selbst gewisse Nebeneinkünfte hatte … Schließlich hatte er sie für die Statistik nach ihrem Nachnamen gefragt und später im Gespräch hatten sie sich auch darüber unterhalten, aus welchem Ort sie stammten. Im Nachhinein konnte Stefan sich nicht mehr vorstellen, auf sowas Blödes hereingefallen zu sein, aber im Urlaub war man halt lockerer und rechnete auch nicht gleich mit dem Schlimmsten.

Tage später klingelte bei Stefan das Telefon und ein Polizeibeamter unterrichtete ihn, dass sein Verdacht begründet gewesen war. Sie waren nicht die einzigen Süd-Urlauber gewesen, deren Wohnung während ihrer Abwesenheit ausgeräumt worden war: Mit Hilfe der spanischen Kollegen hatten man in einer Durchsuchung bei Frank belastendes Material gefunden. Hawaii würde für ihn doch weiterhin nur ein Traum bleiben…

Ergebnis NotebookLM Audio-Diskussion

a) Lokale Ablage nach Umwandlung in MP3: https://www.idethloff.de/blogfiles/20240927/ID-Story-Urlaub-mit-Folgen-NotebookLM.mp3

b) Freigabelink (Google-Anmeldung erforderlich): https://notebooklm.google.com/notebook/9f1de117-e5e1-42d1-953f-edf09e32dd26/audio