Angeregt durch einen Beispiel-Prompt von Nano Banana, nun ein eigener Versuch, thematische Symbole zu erstellen – natürlich wie immer bei meinen KI-Tests anhand des Themenbereichs „Waschbär“.

Gesamtdauer: ca. 10 Minuten

1) Einloggen bei gemini.google.com

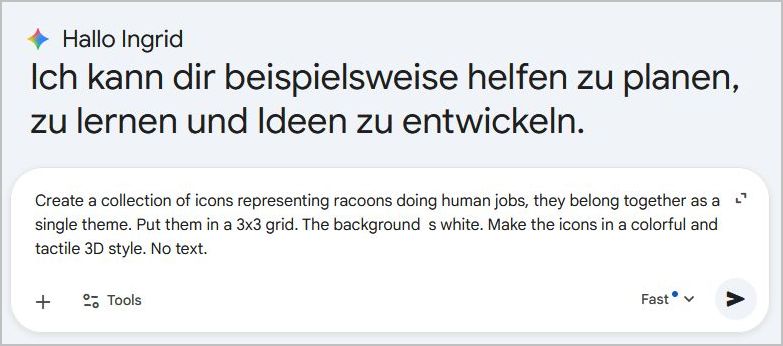

2) Prompt „Create a collection of icons representing racoons doing human jobs, they belong together as a single theme. Put them in a 3×3 grid. The background is white. Make the icons in a colorful and tactile 3D style. No text.“

3) Weitere Ergebnisse anfordern, nun verbunden mit der Aufforderung zur Erläuterung der gezeigten Jobs

Mit mehreren Versuchen und etwas Konkretisierung im Dialog wurden die Ergebnisse recht gut, finde ich. Und Nano Banana merkte selbst, dass bei der Erstellung Fehler passiert waren und schlug vor „I’ve noticed the AI got a little „creative“ by blending some outfits (like the guitar-playing firefighter). Would you like me to try one more grid to get a clean set of specific, distinct jobs like a Pilot, a Yoga Instructor, or a Construction Worker?“

Beim genauen Hinschauen sieht man auch hier noch falsche Kombinationen von Outfits. Lesenswert war auch die Nano Banana Beschreibung zum „lineup for this professional crew“ (s.u.) 😉

*****************************************************************************

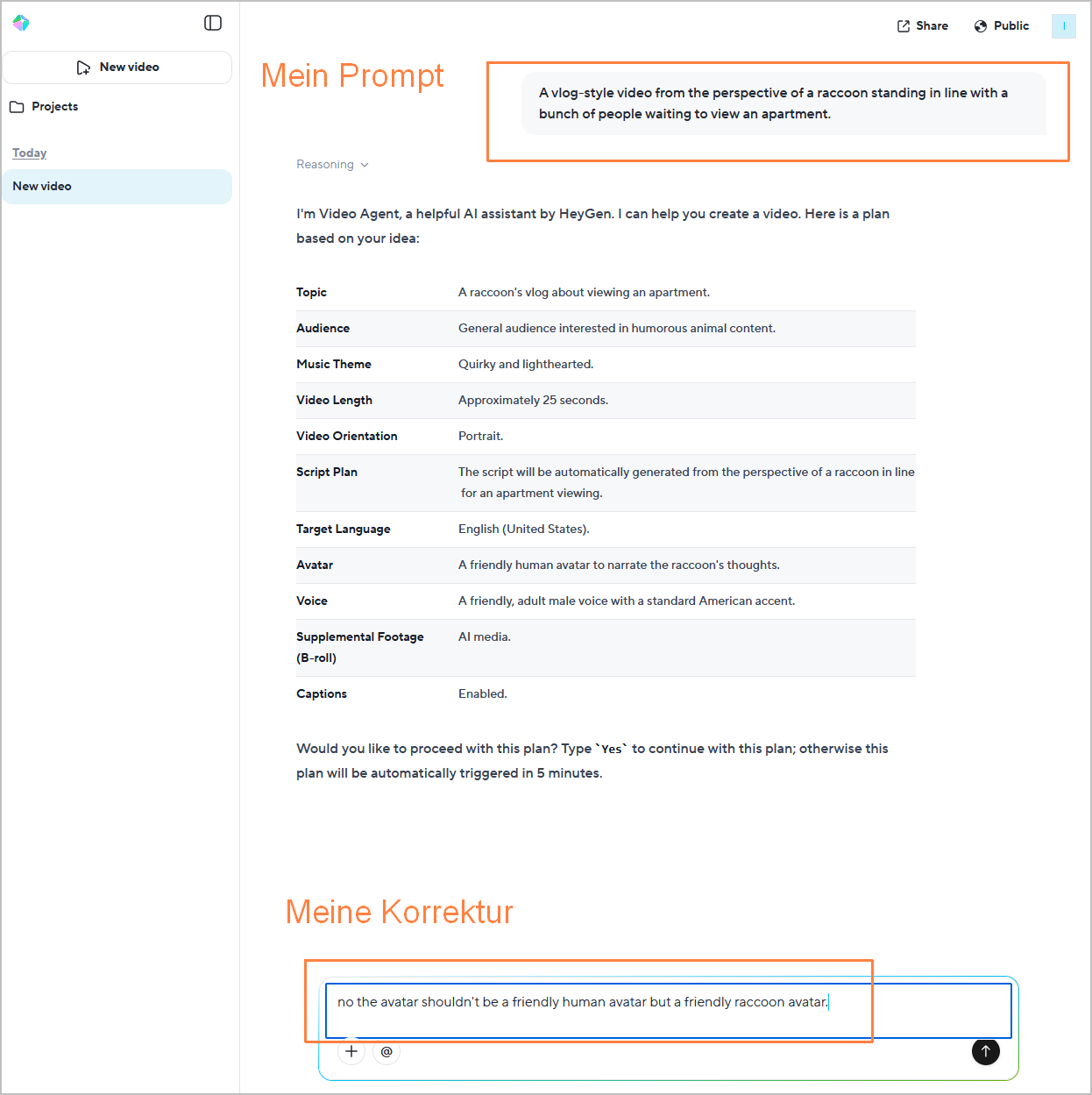

Start-Prompt:

Ergebnis 2:

Ergebnis 4:

Erfragte Beschreibung zum „lineup for this professional crew“:

The Professional Raccoon Collection

The Airline Pilot: Standing tall in a crisp navy uniform with gold stripes and a captain’s hat, he’s ready for takeoff (probably to a destination with high-quality snacks).

The Yoga Instructor: Finding total „zen“ on a colorful mat, this raccoon is proving that even „trash pandas“ can have great flexibility and inner peace.

The Architect/Construction Lead: Reviewing blue prints with a yellow hard hat and a tool belt, he’s clearly the one in charge of the latest neighborhood „build.“

The News Reporter: Dressed in a sharp suit and holding a microphone, he’s reporting live from the city center on the latest dumpster-related breaking news.

The Sunflower Gardener: A very classic gardener look with denim overalls, a straw hat, and a giant sunflower. He’s definitely the one with the green thumb.

The Barista: Hard at work behind a detailed espresso machine, this raccoon is brewing up a „Trash-iato“ for the morning rush.

The Mail Carrier: A dedicated civil servant with a blue uniform and a leather satchel, delivering important letters across the forest.

The Firefighter: Geared up in high-visibility yellow turnout gear with a heavy-duty rope, standing proudly in front of a big red fire truck.

The Librarian: Looking very scholarly with wire-rimmed glasses and a vintage cardigan, he’s making sure the books are returned on time.